Mistral 发布三个小模型

Mistral 的模型发布也跟下仔一样,一周发布了三个模型都不大,不过基本都是同级别最好的,

Mistral NeMo

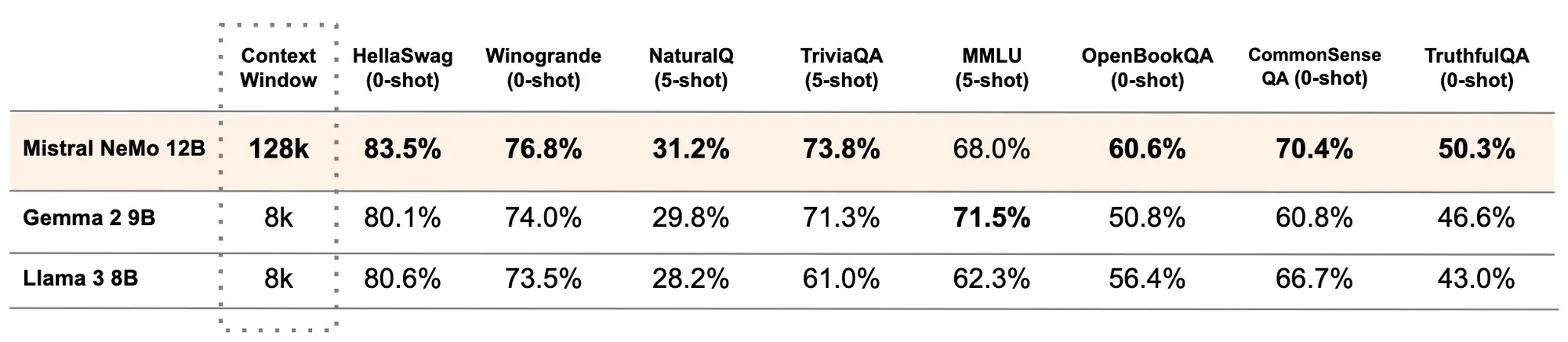

一个 12B 的 LLM。模型有 128K 上下文长度,推理、世界知识和编码准确性都是最好的。

Mistral NeMo在训练过程中考虑了量化(quantisation),可以进行 FP8 无损推理。

模型经过多语言训练,在英语、法语、德语、西班牙语、意大利语、葡萄牙语、中文、日语、韩语、阿拉伯语和印地语方面特别强大。

Mistral NeMo 使用了基于 Tiktoken 的新 Tokenizer Tekken它在超过 100 种语言上进行了训练。 并比之前 Mistral 模型中使用的 SentencePiece tokenizer 更有效地压缩自然语言文本和源代码。

Mistral NeMo 经过了先进的微调和对齐。与 Mistral 7B 相比,它在遵循精确指令、推理、处理多轮对话和生成代码方面要好得多。

MathΣtral 数学模型

这是一个专门针对数学推理和科学发现设计的 7B 型号。32k 上下文窗口,Apache 2.0 许可开源。

模型在 MATH 上达到了 56.6%,在 MMLU 上达到了 63.47% 最重要的是推理能力,这个模型可以通过更多推断时间计算实现明显更好的结果。

推出的那天刚好是阿基米德诞辰 2311 周年。

Codestral Mamba 代码模型

与 Transformer 架构不同,Mamba 模型能够提供线性时间推理的优势,并具备理论上对无限长序列建模的能力。它允许用户大量与模型互动,快速响应,无论输入长度如何。这些特性特别适合用来生成代码。Codestral Mamba最多支持 256K 上下文。

可以使用 mistral-inference SDK 部署 Codestral Mamba,该 SDK 依赖于来自 Mamba GitHub 代码库的参考实现。该模型也可以通过 TensorRT-LLM 进行部署。

Win 11系统之家

Win 11系统之家